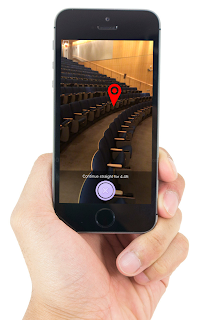

画像引用元:Clew

視覚障害者の移動支援に関する技術開発は、現在世界中でさまざまなプロジェクトが進行している。中でも屋内ナビゲーションについてはBLEビーコンやWi-Fiなどの電波を用いるもの、QRコードを応用したものなどが登場しているが、導入コストやメンテナンス性などそれぞれに課題を抱えており、なかなか本命が見えてきていない。

そのような状況の中、「Clew」は、ARと画像認識を用いることで、ナビゲーションの新しい可能性を感じられるプロジェクトだ。リリースは少し前のようだがApplevisのフォーラムの投稿で知り、興味を持ったのでご紹介。

「Clew」は、米国オーリン・カレッジの学生チームによって開発されている、視覚障害者の移動を支援するiPhone専用アプリ。iOS11で登場した拡張現実プラットホーム「ARKit」を用いて移動ルートを記録し、歩行者をナビゲートするのが特徴だ。

実行にはiOS11以降がインストールされたiPhoneが必要(iPhone 7以降を推奨)。アプリはAppStoreから無料でダウンロードできる;。

Clewの仕組みは、カメラで捉えた移動ルートの風景を解析してARマーカーを作成、。ナビゲーション時にカメラの映像に対応するARマーカーに従って進む方向や階段を振動や音声で伝えてくれる。つまり歩いたルートをiPhoneが「見て」覚えてくれ、帰り道まで案内してくれるというわけだ。

ビーコンや物理マーカーなど特別な設備は一切不要であり、iPhoneの位置情報サービスも使用しない。

現在Clewでできることは、歩行ルートの記録(1ルート)と、その記録を元に出発地まで戻るルート(つまり帰り道)までのナビゲーション。記録したデータの保存はできないため現時点では実用性というよりはARと画像認識を用いたナビゲーション技術を体験する、という用途がメインだろう。原理的には屋外での利用も可能だが、自動車など固定されていないオブジェクトや光の変化が多いと誤動作する可能性が高く、明るさが安定した屋内かつ短距離でのテストが推奨されている。

では実際にClewを用いてナビゲーションを体験してみる。

まずはアプリを起動し、歩行ルートを記録する。

- 出発地点で「Record pass」をタップ。

- iPhoneを顔の高さに垂直にホールドした状態で歩く。

- 目的地に到着したら「Stop recording」をタップ。

ルート記録が完了すると、そのまま帰り道のナビゲーションモードに移行する。iPhoneの位置はそのままの状態をキープ。

なお効果音はiPhoneのサイレントスイッチが有効になっていると鳴らないので注意。

- 「Start nabigation」をタップ。

- iPhoneをホールドしたまま方向を変えると、小さな効果音とともに振動する方向があるので、振動をキープしたままその方向へゆっくり歩く。

- 曲がり角に到着すると効果音(口笛)と共に音声で指示してくれる。方向転換し、引き続き振動をキープさせて歩く。

- 方向を見失ったら「Get direction」をタップすればどちらへ歩けばいいか教えてくれる。

- 目的地に到着すれば音声が流れてナビゲーションが終了する。

筆者は自宅のごく狭い範囲でいくつかのルートを試したが、想像していたより的確なナビゲーションを体験できた。ただ廊下など暗い場所を経由するとうまくARマーカーが記録されないようで、行き詰まることもある(思わず壁にぶつかってしまった)。階段は試すことはできなかった。

なおiPhone設定の「Clew」から距離単位やフィードバックの設定を変更できる。

まだ実験段階のアプリであり実用的に使うのは難しいが、カメラの映像だけで正確なナビゲーションを体験するのは新鮮な驚きがある。ARと画像認識によるナビゲーションは、視覚障害者の移動に大きなインパクトをもたらすと感じさせてくれる体験だった。特別な設備を用意することなく、iPhone一つで歩き回れる日は、案外すぐそこまで来ているのかもしれない。

なお、アプリを試す際は、必ず周囲の安全を確認したうえ出来るだけ見える人に手伝ってもらおう。

関連リンク:

0 件のコメント:

コメントを投稿

注: コメントを投稿できるのは、このブログのメンバーだけです。